في التعلم الآلي ، تعتبر خوارزمية التعزيز Boosting خوارزمية وصفية جماعية وظيفتها الاساسية تقليل التحيز، وكذلك التباين في التعلم الخاضع للإشراف ، أيضا تعتبر كأنها مجموعة من خوارزميات التعلم الآلي التي تحول المتعلمين الضعفاء إلى أقوياء. يعتمد التعزيز على السؤال الذي طرحه كيرنز وفاليانت (1988 ، 1989): “هل يمكن لمجموعة من المتعلمين الضعفاء weak learners تكوين متعلم قوي واحد؟” يُعرَّف المتعلم الضعيف بأنه مصنف يرتبط ارتباطًا طفيفًا فقط بالتصنيف الحقيقي. في المقابل ، المتعلم القوي هو مصنف مرتبط بشكل قوي بالتصنيف الحقيقي.

كان للإجابة الإيجابية لروبرت شابير في ورقته البحثية التي نشرت عام 1990 [5] على سؤال كيرنز وفاليانت تداعيات كبيرة في مجال التعلم الآلي والإحصاء ، وأبرزها أدى إلى تطوير التعزيز boosting.

خوارزمية التعزيز Boosting

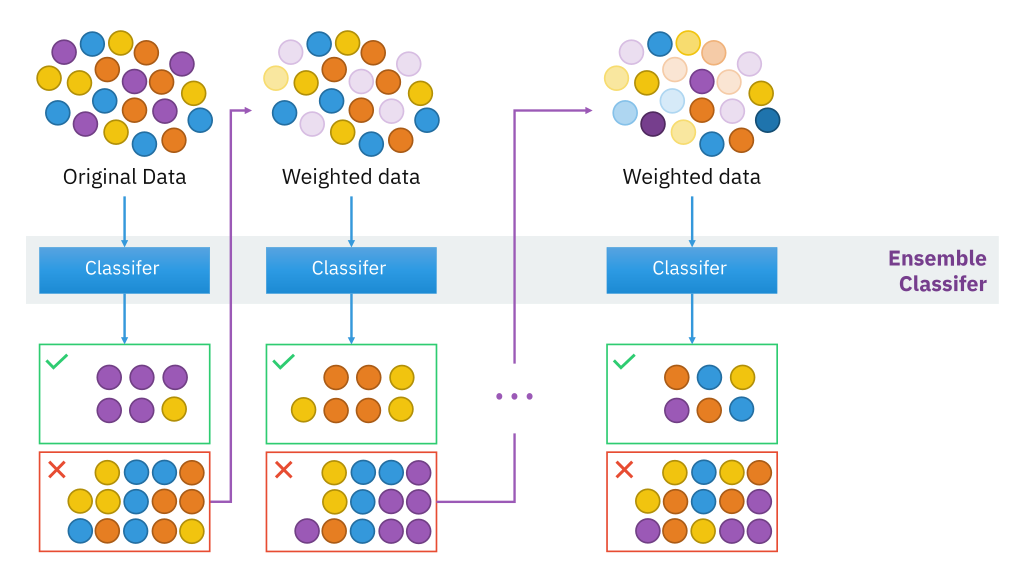

في حين أن التعزيزboosting ليس مقيدًا من الناحية الحسابية ، فإن معظم خوارزميات التعزيز تتكون من التعلم المتكرر للمصنفات الضعيفة فيما يتعلق بالتوزيع وإضافتها إلى مصنف قوي نهائي. عند إضافتها ، يتم ترجيحها بطريقة مرتبطة بضعف دقة المتعلمين. بعد إضافة متعلم ضعيف ، يتم إعادة ضبط أوزان البيانات ، المعروفة باسم “إعادة توزيع الأوزان re-weighting “. تكتسب بيانات المدخلات الخاطئة وزناً أعلى والأمثلة المصنفة بشكل صحيح تفقد الوزن. [ملاحظة 1] وبالتالي ، يركز المتعلمون الضعفاء في المستقبل أكثر على الأمثلة التي أخطأ المتعلمون الضعفاء السابقون في تصنيفها.

الرسم التوضيحي أعلاه يوضح الحدس الكامن وراء خوارزمية التعزيز ، وتألفها من متعلمين متوازيين ومجموعة بيانات موزونة parallel learners and weighted dataset.

هناك العديد من خوارزميات التعزيز. لم تكن النماذج الأصلية ، التي اقترحها روبرت شابير (صيغة بوابة الأغلبية التكرارية) ويواف فرويند (التعزيز بالأغلبية) ، قابلة للتكيف ولم يكن يمكنها الاستفادة الكاملة من المتعلمين الضعفاء. حيث قام شابير وفريوند بتطوير خوارزمية AdaBoost ، وهي خوارزمية تعزيز تكيفية adaptive boosting algorithm فازت بجائزة Gödel المرموقة.

فقط الخوارزميات التي يمكن إثباتها في تعزيز الخوارزميات في صيغة التعلم الصحيحة تقريبًا يمكن أن تسمى بدقة خوارزميات التعزيز. الخوارزميات الأخرى المتشابهة في الروح [بحاجة إلى توضيح] لتعزيز الخوارزميات تسمى أحيانًا “خوارزميات الاستفادة” ، على الرغم من أنها تسمى أحيانًا بشكل غير صحيح خوارزميات التعزيز.

الاختلاف الرئيسي بين العديد من خوارزميات التعزيزboosting هو طريقتهم في ترجيح نقاط بيانات التدريب والفرضيات. تحظى AdaBoost بشعبية كبيرة والأكثر أهمية تاريخيًا لأنها كانت أول خوارزمية يمكن أن تتكيف مع المتعلمين الضعفاء. [10] هناك العديد من الخوارزميات الحديثة مثل LPBoost و TotalBoost و BrownBoost و xgboost و MadaBoost و LogitBoost وغيرها. تتلاءم العديد من خوارزميات التعزيز مع إطار عمل AnyBoost ، [9] والذي يوضح أن التعزيز boosting يتحول إلى خورزمية أ gradient descent في فضاء دالي Function space باستخدام دالة وظيفية محدبة convex cost function.

خوارزميات التعزيز المحدبة مقابل الغير محدبة

يمكن أن تستند خوارزميات التعزيز إلى خوارزميات تحسين محدبة أو غير محدبة convex or non-convex optimization algorithms. الخوارزميات المحدبة ، مثل AdaBoost و LogitBoost ، يمكن “أن تقل كفائتها” بالضوضاء العشوائية بحيث لا يمكنها تعلم التركيبات الأساسية والقابلة للتعلم من الفرضيات الضعيفة. تمت الإشارة إلى هذه السلبية من قبل Long & Servedio في عام 2008. ومع ذلك ، بحلول عام 2009 ، أظهر العديد من الباحثين أن تعزيز الخوارزميات القائمة على التحسين غير المحدب ، مثل BrownBoost ، يمكن أن تتعلم من مجموعات البيانات العشوائية ويمكن أن تتعلم على وجه التحديد المصنف الأساسي لـ Long- مجموعة بيانات Servedio.

يمكن تشغيل هذه الخوارزمية على البيئات البرمجية التالية

- مكتبة Scikit-Learn ، مكتبة تعلم الآلي مفتوحة المصدر في لغة البرمجة بايثون

- برنامج Orange ، عبارة عن مجموعة برمجيات مفتوحة المصدر تستخدم في مجال التنقيب في البيانات و خوارزميات تعلم الألة ، الوحدة النمطية Orange.ensemble.

- برنامج Weka ، عبارة عن مجموعة من أدوات التعلم الآلي التي تقدم تطبيقات متنوعة لتعزيز الخوارزميات مثل AdaBoost و LogitBoost.

- حزمة R GBM (نماذج الانحدار المعزز المعمم) تنفذ امتدادات لخوارزمية AdaBoost من Freund و Schapire وآلة تعزيز التدرج من Friedman.

- jboost. AdaBoost و LogitBoost و RobustBoost و Boostexter وأشجار القرار البديلة

- حزمة R adabag: تطبق Multiclass AdaBoost.M1 و AdaBoost-SAMME والتعبئة

- R package xgboost: تنفيذ تعزيز التدرج للنماذج الخطية والقائمة على أشجار القرار.